一、工具及环境准备

-

Pycharm

-

Python3.7.3

二、网页分析

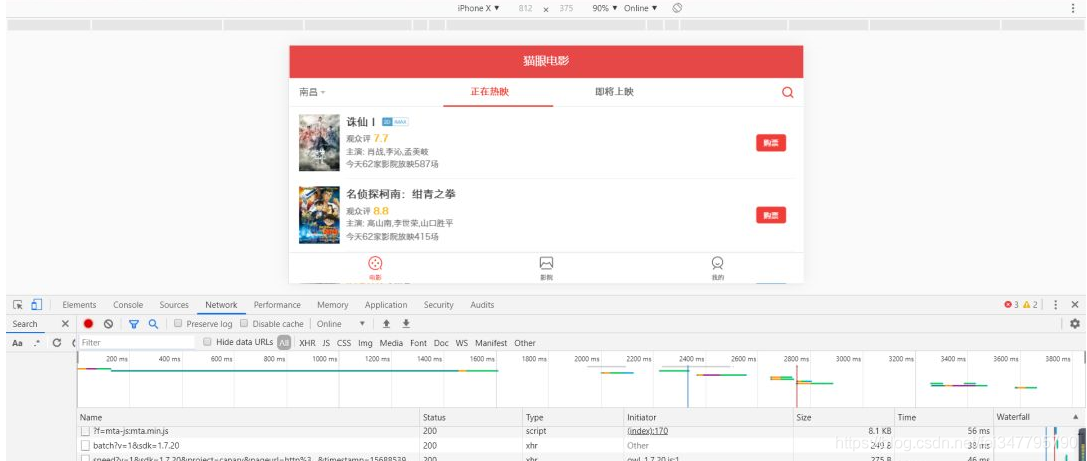

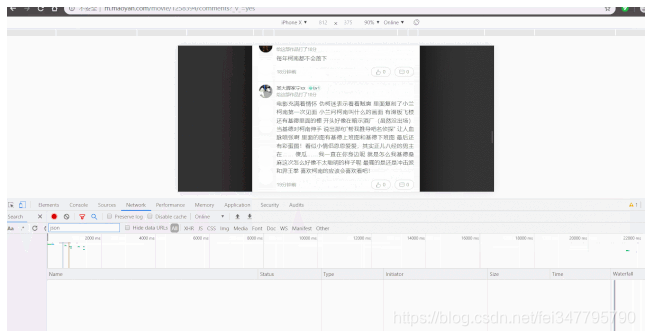

打开猫眼电影官网,发现猫眼电影在电脑网页上看不了很多的评论,于是小编打开开发者模式(按F12),并将其切换到手机端模拟状态。就是下面这个样子:

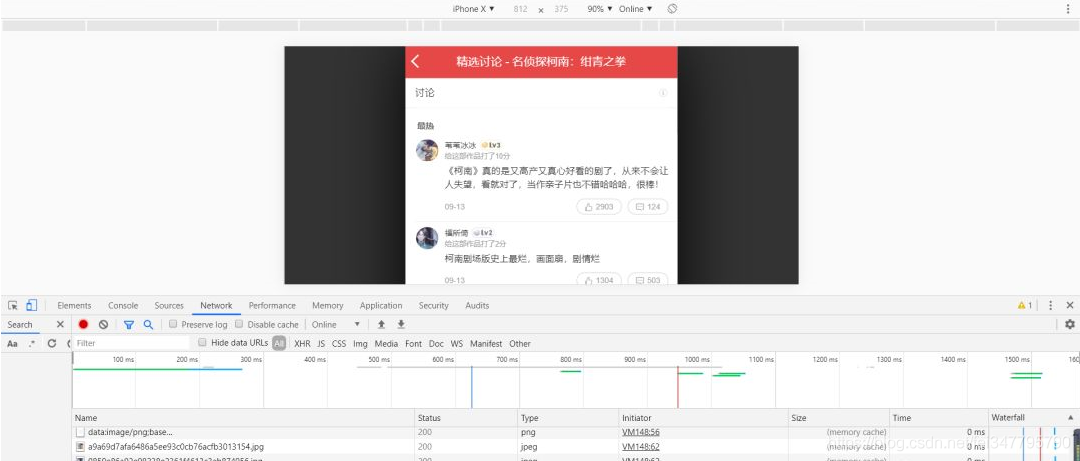

然后,点击柯南的那一栏直到出现评论:

之后小编就在想,前后端数据的传输肯定是以json格式传输,于是小编就在过滤器那里输入json过滤出json数据,额,,,发现什么都没有,有点尴尬:

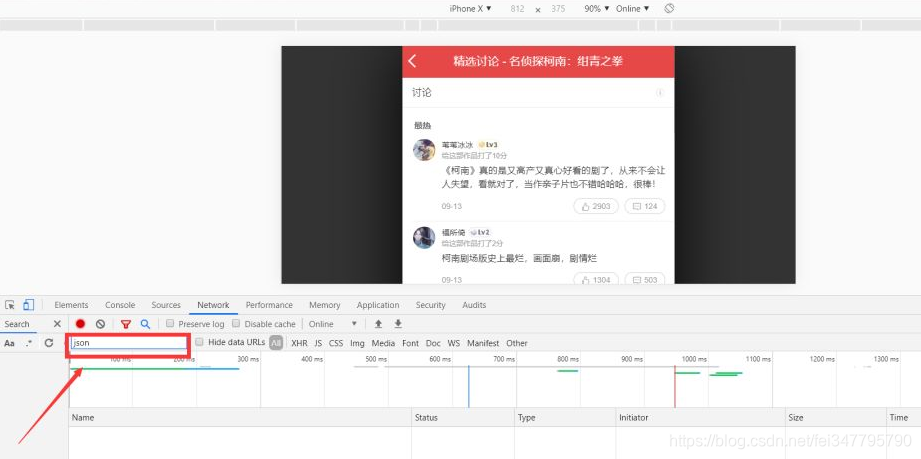

不过别急,等我往下滑就出来了:

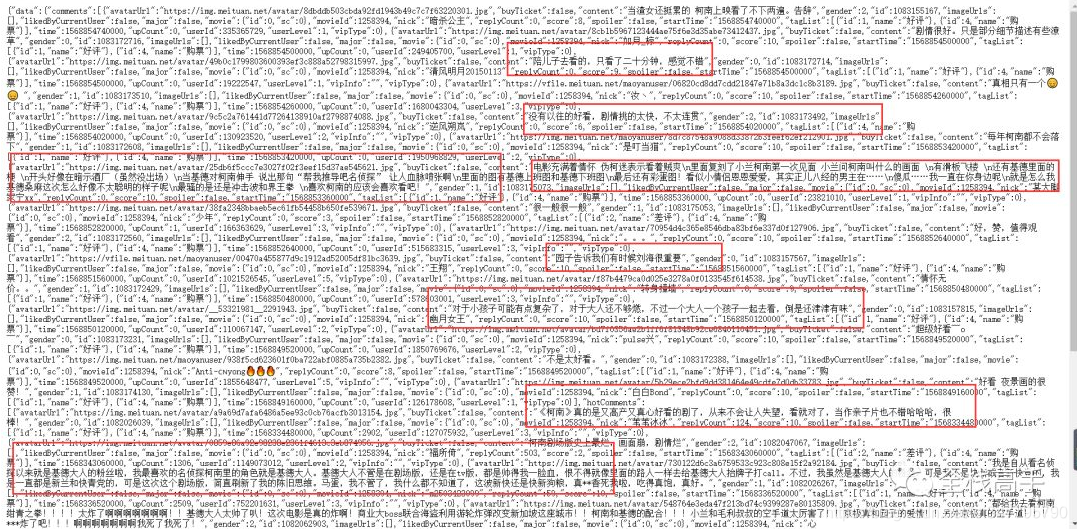

这样,相关的json数据就出来了,然后我们双击看一下是不是我们想要的评论:(密集恐惧者慎入)

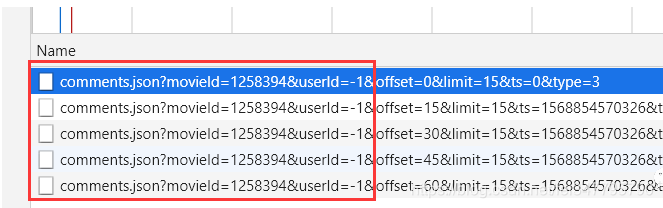

接下来我们继续分析json数据接口url的特点和json格式数据中评论所在的地方,分析发现url的前面都是这样:

而变化的是后面的offset和ts,而且offset是从0开始之后每个增加15来开始增加的,而后面的ts则是一个长达13位的数据,不过如果对数字十分敏感的同学来说,1568854570326则是当前时间的毫秒级显示:

三、代码编写

import requests

import time

import json

import random

import codecs

'''

更多Python学习资料以及源码教程资料,可以在群1136201545免费获取

'''

# 伪装成浏览器

my_headers = {

'User-Agent':'Mozilla/5.0 (Windows NT 10.0;Win64; x64) '

'AppleWebKit/537.6 (KHTML),like Gecko Chrome/61.0.3613.00 '

'Safari/537.36',

'Referer':'http://m.maoyan.com/movie/1258394/comments?_v_=yes'

}

def requestURL():

baseUrl = 'http://m.maoyan.com/review/v2/comments.json'

off = 0

time_now = (int)(round(time.time()*1000))

for i in range(400):

parame = {

'movieId':'1258394',

'userId':'-1',

'offset':off,

'limit':'15',

'ts':time_now,

'type':'3'

}

off+=15

r = requests.get(baseUrl,params=parame,headers=my_headers,timeout=5)

if r.status_code==200:

data = json.loads(r.text)

commentList = data['data']['comments']

time_now = (int)(round(time.time()*1000))

writeToFile(commentList,off)

time.sleep(random.random())

else:

print(r.status_code)

def writeToFile(comments,off):

fileName = '电影评论.txt'

with codecs.open(fileName,'a+',encoding='utf-8') as f:

for contain in comments:

f.write(str(contain['content'])+'\n')

f.close()

print("已经爬取",off,"条数据")

if __name__=='__main__':

requestURL()

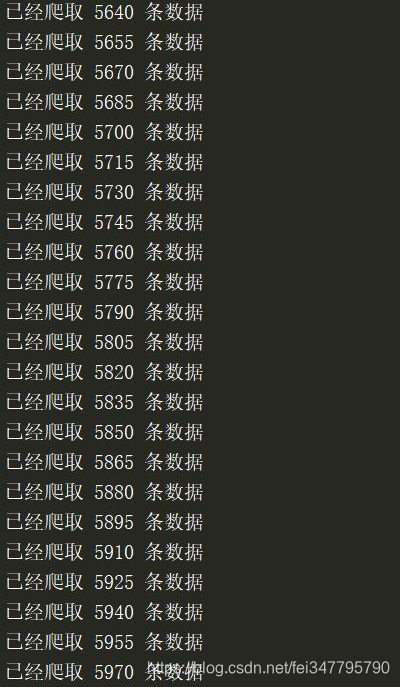

爬取过程:

爬取结果:

四、对评论进行数据分析

代码如下:

import numpy as np

from wordcloud import WordCloud

import PIL.Image as image

import codecs

if __name__=='__main__':

with codecs.open("电影评论.txt",encoding='utf-8') as fp:

text = fp.read()

mask = np.array(image.open("柯南.jpg"))

wordcloud = WordCloud(mask=mask,background_color='white').generate(text)

wordcloud.to_file('词云柯南.jpg')

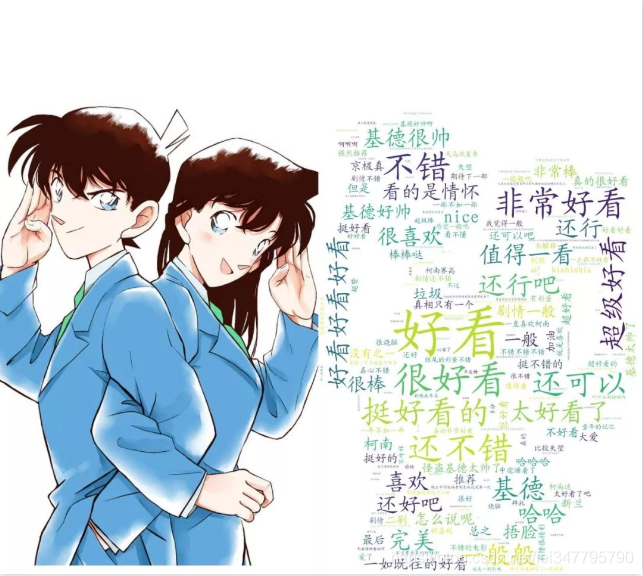

生成的词云图如下:

(柯哀党勿喷)