朋友的小老弟最近想找工作,但是不知道做什么合适,喊我帮忙,我能怎么办呢,那只能使出我祖传的Python大法了!

对于Python来说,找个工作不是很简单的事情吗,于是我直接用Python把所有的岗位信息都爬下来了,顺便做个数据分析,今天给大家分享一下爬虫部分吧~

这是要用的软件,先准备好

python 3.6

pycharm

要用的模块,没安装的铁汁记得安装,不然分分钟报错就难受~

requests >>> pip install requests

re

json

csv

time

爬虫的实现过程:

一. 数据来源分析

1. 确定爬取数据

2. 确定数据来源

通过开发者工具进行抓包分析

二. 代码实现

1. 发送请求

2. 获取数据

3. 解析数据

4. 保存数据

5. 多页爬取

老样子,模块先安排好。

import requests

import re

import json

import pprint

import csv

import time

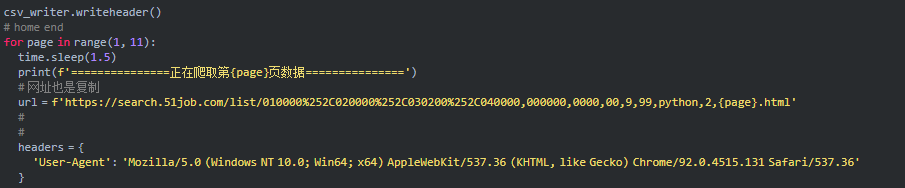

创建好表格和格式

f = open('招聘1.csv', mode='a', encoding='utf-8', newline='')

csv_writer = csv.DictWriter(f, fieldnames=['标题', '公司', '地区', '经验', '学历', '薪资', '福利', '发布时间', '详情页'])

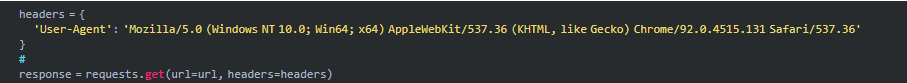

url复制过来,把python代码伪装成浏览器发送请求,复制过来的请求头

数据解析 re正则表达式[.*?] css选择器 xpath 根据标签内容来提取

正则提取字符串数据内容

索引取值

html_data = re.findall('window.__SEARCH_RESULT__ = (.*?)</script>', response.text)[0]

json_data = json.loads(html_data)['engine_search_result']

标题啊福利薪资等等大家关系的内容统统安排上,然后打印输出

for index in json_data:

title = index['job_title'] # 标题

job_welf = index['jobwelf'] # 福利

money = index['providesalary_text'] # 薪资

job_href = index['job_href'] # 详情页

date = index['updatedate'] # 发布时间

company_name = index['company_name'] # 公司

area = index['attribute_text'][0] # 地区

exp = index['attribute_text'][1] # 经验

edu = index['attribute_text'][2] # 学历

dit = {

'标题': title,

'公司': company_name,

'地区': area,

'经验': exp,

'学历': edu,

'薪资': money,

'福利': job_welf,

'发布时间': date,

'详情页': job_href,

}

csv_writer.writerow(dit)

print(dit)

截图的部分没办法,不然过不了审

基础不好的同学看不明白的话,有视频讲解,包括完整代码,或者从零基础开始的教程、软件等等都可以 点我免费加群领取 包括有学习的问题都可以在群里问。